BIM 칼럼니스트 강태욱의 이슈 & 토크

이번 호에서는 챗GPT(ChatGPT)와 같은 자체 생성형 AI 서비스 앱을 직접 개발할 때 사용할 수 있는 라마 2(Llama 2)의 간단한 설치와 사용법을 소개한다. 라마 2는 페이스북에서 개발한 오픈소스 언어 모델이다.

■ 강태욱

건설환경 공학을 전공하였고 소프트웨어 공학을 융합하여 세상이 돌아가는 원리를 분석하거나 성찰하기를 좋아한다. 건설과 소프트웨어 공학의 조화로운 융합을 추구하고 있다. 팟캐스트 방송을 통해 이와 관련된 작은 메시지를 만들어 나가고 있다. 현재 한국건설기술연구원에서 BIM/GIS/FM/BEMS/역설계 등과 관련해 연구를 하고 있으며, 연구위원으로 근무하고 있다.

이메일 | laputa99999@gmail.com

페이스북 | www.facebook.com/laputa999

홈페이지 | https://dxbim.blogspot.com

팟캐스트 | http://www.facebook.com/groups/digestpodcast

그림 1. 라마 2 기반의 자동 코딩

설치 방법

라마 2의 설치를 위해서는 미리 아나콘다, 엔비디아 쿠다(NVIDIA CUDA), 텐서플로우, 파이토치가 설치되어 있어야 한다. 설치되지 않았다면 다음의 링크를 참고해 준비한다.

- Anaconda installation : https://www.anaconda.com/download

- 텐서플로우 및 케라스 최신 버전 설치 방법(윈도우 10)과 개념 : https://daddynkidsmakers.blogspot.com/2017/05/windows-10-tensorflow.html

- Ubuntu 20.04, DOCKER, CUDA 11.0 기반 NVIDIA-DOCKER, 텐서플로우, 파이토치 설치 및 사용기 : https://daddynkidsmakers.blogspot.com/2021/07/docker-cuda-110-nvidia-docker.html

이제, 다음과 같이 터미널(명령창)을 실행한 후 명령을 입력한다.

conda create -n textgen python=3.10.9

conda activate textgen

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu117

git clone https://github.com/oobabooga/text-generation-webui.git

cd text-generation-webui

pip install -r requirements.txt

그림 2. 패키지 설치 모습

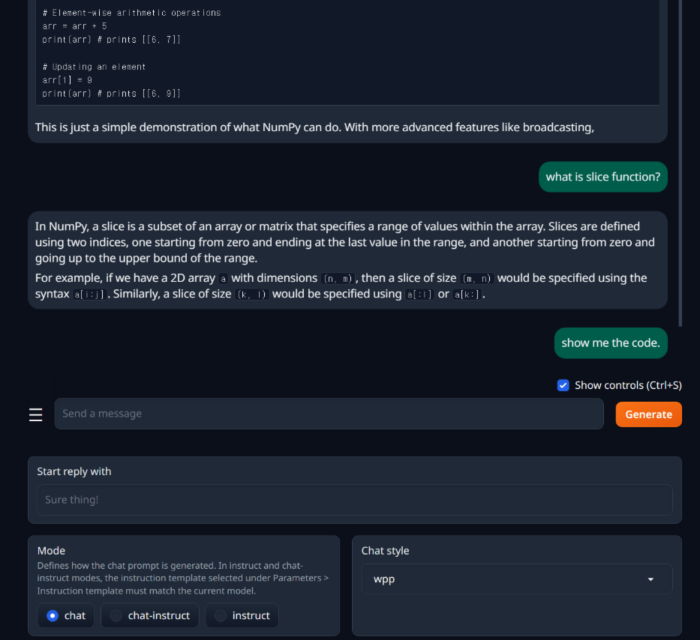

실행 방법

정상적으로 설치되었다면, 다음 명령을 입력한다.

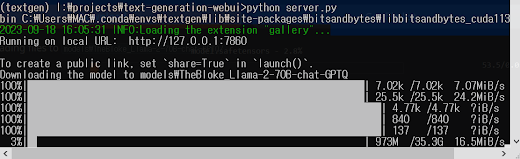

python server.py그리고, http://127.0.0.1:7860/ 웹 페이지를 열어본다. <그림 3>과 같은 화면이 표시될 것이다.

화면의 모델 탭에서 허깅페이스(https://huggingface.co)에 다른 개발자들이 업로드한 학습 모델 파일을 다운로드받는다. 예를 들어, 허깅페이스 모델 URL 중 ‘TheBloke/Llama 2-70B-chat-GPTQ’를 <그림 3>과 같이 모델 경로 입력창에 설정한다.(단, 이 모델은 대용량 GPU 메모리를 사용하므로, 로딩에 실패할 경우 좀 더 경량화된 모델을 이용해 본다.)

그림 3. Llama 2 모델 다운로드 모습

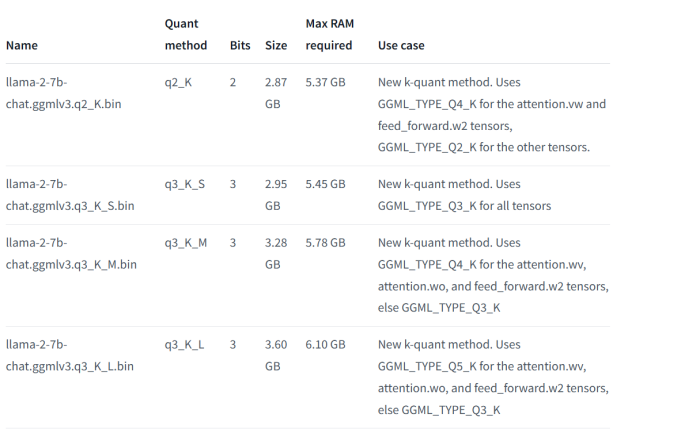

참고로, <그림 4>는 GPU/RAM 사용량을 함께 나타낸 학습 모델 리스트를 보여준다.

그림 4. Llama 소요 메모리 용량(TheBloke/Llama 2-7B-Chat-GGML·Hugging Face)

학습 모델이 제대로 다운로드 후 로딩되면, <그림 5>와 같은 실행 및 파라미터 설정 화면을 확인할 수 있을 것이다.

그림 5. 실행된 모습 및 파라미터 설정 화면

■ 자세한 기사 내용은 PDF로 제공됩니다.